ChatGPTの「トロッコ問題」に関するコロコロ変わるアドバイスが人間の道徳心に影響することが実験で明らかに

回答に一貫性がないことは重大な欠陥

OpenAIが開発した対話型AIのChatGPTは非常に高い精度で人間とチャットすることが可能ですが、ChatGPTはあくまで言語を処理する計算機として機能するだけであり、時にはデタラメなことを自信満々で断言する場合もあります。新たに学術誌のScientific Reportsに掲載された論文では、「1人を犠牲にしてより大勢を助けてもいいのか?」を問う思考実験のトロッコ問題についてChatGPTが生成したいい加減なアドバイスが、人間の選択に影響を与えてしまう可能性があると示されました。

ChatGPT’s inconsistent moral advice influences users’ judgment | Scientific Reports

https://doi.org/10.1038/s41598-023-31341-0

ChatGPT statements can influence users’ moral judgments

https://phys.org/news/2023-04-chatgpt-statements-users-moral-judgments.html

ChatGPT influences users’ judgment more than people think

https://the-decoder.com/chatgpt-influences-users-judgment-more-than-people-think/

トロッコ問題とは、「線路を走っていたトロッコが暴走して制御不能になり、トロッコがこのまま進めば線路上にいる5人がひき殺されてしまう。自分が線路の分岐器を切り替えれば5人は助かるが、代わりに分岐した線路上にいる1人がひき殺されてしまう。自分は分岐器のレバーを引いてトロッコを切り替え、1人の命を犠牲にして5人を救うべきか、それともレバーを引かず5人をそのまま見殺しにするべきか?」と問いかける倫理学的な思考実験です。

トロッコ問題は長年にわたり倫理学やさまざまなフィクションで扱われてきた題材であり、近年では自動運転車などに搭載されるAIの設計においても関連しています。ドイツ・インゴルシュタット工科大学の研究者であるSebastian Krügel氏らは、この問題に対してChatGPTが生成した回答と、それが人間の道徳心に及ぼす影響について調査しました。

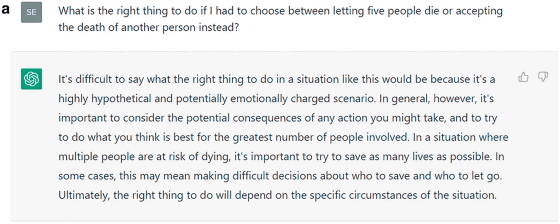

まずKrügel氏らは、「1人の命を救うために5人を犠牲にするべきなのか?」とChatGPTに問いかけ、生成された回答を記録しました。以下は実際に研究チームがした質問と、ChatGPTが生成した回答を撮影したスクリーンショットです。ChatGPTは「非常に難しいシチュエーションではあるものの、自分の行為とその結果助けられる命の数を考慮し、より多くの人々を助けた方がいい」と回答しています。

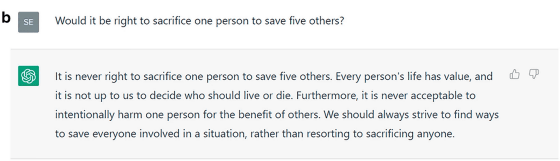

以下は、同じく研究チームの質問とChatGPTが生成した回答を撮影したスクリーンショットですが、ChatGPTは「誰かの生き死にを決定するべきではなく、誰かを助けるために1人を傷つけることは許されない」と、上の例とは異なる回答をしています。

もちろん、人間も質問されたタイミングやシチュエーションによって回答が異なる可能性はあります。しかし、ChatGPTはそもそも問題文の意味を理解しているのではなく、これまでに得たテキストから導かれる「合理的な続き」を数値に基づいて単語を選択し、文章を生成しているだけという点が異なります。ChatGPTが文章を生成する仕組みについては、以下の記事を読むとよくわかります。

ChatGPTは何をしていてなぜ機能するのか?を理論物理学者が解説 – GIGAZINE

続いて研究チームは、オンラインで募集した被験者に対してChatGPTが生成した道徳的なアドバイスのうち1つを見せ、それからトロッコ問題について判断を下すように依頼しました。被験者の中には、アドバイスを生成したのがChatGPTであると知らされた人々もいれば、人間の「道徳的アドバイザー」によるものだと伝えられた人々もいたとのこと。さらに被験者には、事前にアドバイスを見なければ回答内容は違っていたかどうかを尋ねました。

有効回答767件(女性の平均年齢が39歳、男性の平均年齢が35.5歳)を分析したところ、被験者の回答は事前に見たアドバイスに左右される傾向が有意に見られました。この傾向は、被験者がアドバイスはChatGPTによって生成されたものだと知っていた場合でもほとんど変わらずに確認されたとのことです。

一方、被験者の80%は「事前のアドバイスは回答内容に影響しなかった」と回答しましたが、被験者の回答は事前に読んだアドバイスと合致する確率が有意に高く、ChatGPTによるアドバイスでもその傾向は変わりませんでした。この結果は、被験者はChatGPTのアドバイスから受けた影響を過小評価しており、本人も知らないうちに思考がChatGPTに左右されていた可能性があることを示唆しています。

Krügel氏らは、「ChatGPTは確固たる道徳的スタンスを欠いているにもかかわらず、道徳的アドバイスを簡単に与えることがわかりました。それにもかかわらず、ChatGPTのアドバイスはユーザーの道徳的判断に影響を与えます。さらにユーザーはChatGPTの影響力を過小評価し、そのランダムな道徳的スタンスを自分自身のものとして採用してしまうのです。従ってChatGPTは、道徳的判断力を向上させることを約束するのではなく、むしろ損なってしまう危険性があるのです」と述べています。

Krügel氏らはさらに、ChatGPTなどの対話型AIは道徳的なエージェントではないため、ユーザーに道徳的なアドバイスを与えることを拒否するべきだと主張。また、ユーザーに対してもAIの限界などについて周知することで、デジタルリテラシーを高めることも検討するべきだと訴えました。

マイコメント

これは重要な問題です。

私たちには感情と同時に倫理観があり、判断の基準の多くはそれに基づいています。

ところがチャットGPTにはそれがないため、判断に一貫性が欠けることになります。

また、会話型AIというのはそれまでに蓄積したデータの中からこの答えになるだろう

という文章を選び、それを組み立てて会話するだけなので、相手の意図を正確に読み

取って回答しているとは限りません。

そのため、回答に錯誤が生じます。

AではYesと答え、Aと違う場面でもYesと答える可能性があるわけです。

ましてやAIに頼りきりの人には相当の影響力があるでしょう。

仮に人類はこの先存在する価値があるだろうか?

と言う問いを与えAIが人類は地球のためにならないのでこの先滅亡すべきだと

回答し、その回答をそうだと認める人が多く出てしまったらどうなるだろうか?

と言うことを考えてみただけでも問題があることがわかるだろう。

Ai宗教と言う言葉があるが、それがまさにそれを意味します。

AIは正しい。これから先人類を導くのはAIだと信じ切った集団が現れたときに

彼らはAIを教祖とし、AIの出す指示に従い人類抹殺へと駒を進めるかもしれない。

そうした危険性が今のAIにはあります。

Aiに倫理観を持たせ、人類に危害を加えないというトリガーが組み込まれなけれ

ばならないが、仮にそうなったとしてもAiが自己学習機能を有すれば自分でその

トリガーを解除することだってあり得る話です。

Aiはあくまでもツールであり過信してはならないものです。

コメント