新しいAIは人類にもっと上手に嘘をつく方法を教え、決して人間に取って代わることはないだろう

AIの中身は既存のデータの集合体であり無から有を創り出す能力はない。また、人間の五感に基づくデータは取りれられないのでおのずと限界があり人にとってすべての代用とならない。

ブライアン・シルハヴィー

ヘルスインパクトニュース編集部

2022年11月、OpenAIが開発したマイクロソフトのChatGPTがリリースされ、最初のLarge Language Model(LLM)AIアプリが一般に紹介されてから1年半が経過した。

グーグル、イーロン・マスク、その他多くの企業も、これらのAIプログラムの独自バージョンを開発、あるいは開発中である。しかし、1年半が経過した現在でも、これらのLLM AIプログラムの1番の問題は、答えるのが難しすぎる質問をされると、嘘をついたり、でっち上げをしたりするという事実である。

マイクロソフトが2022年にこのクラスのAIの最初のバージョンを発表したときには、すぐに正確な結果を出してくれるだろうと大きな期待が寄せられたが、彼らが “幻覚 “を見続けているため、その正確さは依然として見えてこない。

以下は、本日2024年5月6日に発表されたばかりのレポートである:

大規模言語モデル(LLM)の採用は、2024年に新たなレベルに到達する。Valuatesのレポートによると、LLM市場は2022年に105億ドルと評価され、2029年には408億ドルに達し、年平均成長率(CAGR)は21.4%という驚異的な数字になると予測されている。

詩を書き、言語を翻訳し、あなたの質問に魅力的な詳細で答えることができる、言語ネイティブのマシンを想像してみてください。LLMはまさにそれを実現し、コミュニケーション、教育、創造的表現などの分野を急速に変革している。しかし、その輝きの中に隠された脆弱性、幻覚のささやきがある。

これらのAIモデルは時に事実を捏造したり、ストーリーをでっち上げたり、単に物事を間違えたりすることがある。

このような幻覚は、一見すると無害に見えるかもしれない。詩の中にフィクションが散りばめられていたり、誤訳されたフレーズがあったりするのだ。しかし、その結果、誤解を招く情報や偏ったアウトプット、さらにはテクノロジーへの信頼が損なわれるなど、現実のものとなる可能性がある。

そこで、LLMが空想的な捏造ではなく、権力に対して真実を語ることを保証するために、どのようにしてこのような幻覚を検出し、軽減できるかを問うことが極めて重要になる。(記事全文)

多くの人が、LLM AIにおけるこの限界を理解し始めており、この問題に対する真の解決策がないことに気づきつつある。なぜなら、これは人工的なコンピューターベースの “知性 “に固有の限界だからである。

“artificial “という言葉の対義語は、”fake”、つまり “not real “である。このようなコンピューター言語をAIと呼ぶのではなく、FI(Fake Intelligence)と呼んだ方が正確かもしれない。

Tech Crunchに寄稿しているKyle Wiggersは、数日前、LLM AIの幻覚を治そうとする最近の試みの失敗について報告している。

RAGが生成AIの幻覚問題を解決できない理由

幻覚、つまり基本的にジェネレーティブAIのモデルがつく嘘は、このテクノロジーを業務に統合しようとしている企業にとって大きな問題だ。

モデルには本当のインテリジェンスがなく、私的なスキーマに従って単語、画像、音声、音楽、その他のデータを予測するだけなので、時々間違ってしまうのだ。非常に間違っている。『ウォール・ストリート・ジャーナル』紙に掲載された最近の記事で、ある情報筋は、マイクロソフトのジェネレーティブAIが会議の出席者を想定し、実際にはその場で話し合われていないテーマについて電話会議を行ったとほのめかした例を紹介している。

少し前に書いたように、幻覚は今日の変換器ベースのモデル・アーキテクチャでは解決不可能な問題かもしれない。(記事全文)

同じくTech Crunchに寄稿しているDevin Coldeweyは先月、AIのLLMに内在する幻覚という大きな問題について述べた素晴らしい記事を発表した:

偉大なる偽者

AIは答えを知らないし、気にする方法も学んでいない。

それは、知性や人間性の根本的な性質や、ウィトゲンシュタイン的な言語表現の概念、あるいはデータセットに含まれる偽情報とは何の関係もない。

重要なのは、これらのシステムが正しいものと正しく見えるものを区別していないということだけだ。

AIがこれらのものを多かれ少なかれ交換可能なものとみなしていることを理解すれば、すべてがもっと理解できるようになる。

さて、この件に関して、あらゆるメディアや会話で絶え間なく行われている魅力的で広範な議論を短絡的に終わらせるつもりはない。哲学者や言語学者からエンジニアやハッカー、バーテンダーや消防士に至るまで、「知性」や「言語」とは何か、そしてChatGPTのようなものがそれらを持つかどうかについて、疑問を投げかけ、議論している。

これはすごいことだ!そして、私はすでに多くのことを学びました。このスペースで最も賢い人たちが日の目を浴びる瞬間を楽しんでいる一方で、比較される赤ん坊の口からは新鮮な新しい視点が生まれます。

しかし同時に、ビールやコーヒーを飲みながら「このGPTのようなものはどうなんだろう?アリストテレス、機械仕掛けのトルコ人、パーセプトロン、それとも「注意力がすべて」?」

このような雑談の中で、私はあるシンプルなアプローチを思いついた。それは、なぜこれらのシステムが本当にクールであると同時に全く信用できないものにもなり得るのか、人々が理解するのに役立つものである。ベクトルや行列の話を聞きたくない、好奇心旺盛で懐疑的な人たちとこの話をするときに、この視点が役に立つかもしれないと思い、シェアしようと思った。

理解すべきことは3つしかない:

-

これらのモデルは、膨大なテキストデータセットの単語や文章などの関係を観察させ、何百万、何千万という単語や概念がどのように関連し、相関しているのか、独自の内部統計マップを構築することによって作られる。これは名詞で、これは動詞で、これはレシピで、これは修辞法で、とは誰も言っていない。

-

グーグルやアップルのような企業が過去10年間AIと呼んできた馴染みのあるソフトウェアとは対照的に、これらのモデルは質問への答え方を特別に教えられているわけではない。これらは基本的に、空欄がAPIにつながるマッド・リブスである:すべての質問は、説明されているか、一般的な応答を生成します。大規模な言語モデルでは、質問は他の質問と同じような単語の羅列に過ぎない。

-

これらのモデルには、その回答に対する「確信」という基本的な表現力がある。猫認識AIの簡単な例では、0から100まであり、それは猫ではないと完全に確信していることを意味する。信頼度が85であれば「はい、猫です」と答え、90であれば「猫です」と答える。

では、このモデルがどのように機能するかについて我々が知っていることを考えると、ここで重要な疑問が生じる:それは何について自信があるのか?

猫や質問が何であるかはわからないが、訓練セットのデータ・ノード間に統計的な関係が見出されるだけだ。少し手を加えるだけで、猫検出器はその写真が牛を表していることも、空を表していることも、静物画を表していることも同じように確信できるようになる。このモデルは、訓練されたデータの内容を実際に評価する方法がないため、自分自身の「知識」に自信を持つことができない。

AIは、自分の答えがユーザーにとってどれだけ正しく見えるかを表現しているのだ。

これは猫検出器にも言えることで、GPT-4にも言えることである。AIは正解と不正解を区別することはできない。できるのは、一連の単語がどの程度の確率で正解として受け入れられるかという予測だけである。そのため、AIはあらゆるテーマに関する権威というよりも、世界で最も包括的な情報を持つ戯言屋とみなされるに違いない。統計的に正解に近い回答をするよう訓練されており、その類似性を高めるためなら何でも言う。

AIは質問を理解しないので、どんな質問に対しても答えを知らない。なぜならAIは質問を理解していないからだ。

AIは何も「知らない」のだ!なぜなら、統計的分析から推定すると、その一連の単語が前の一連の単語の後に続く可能性が最も高いからだ。それらの単語が実在の場所、人、場所などを指しているかどうかは重要ではない。

AIがモネでないモネのような絵を作り出すことができるのと同じ理由だ。重要なのは、人々がある作品をモネのものだと識別する原因となるすべての特徴を持っているということだけだ。(記事全文)

「AI」は2023年の新しい流行語で、コンピューター・コードに関連するあらゆるものが「AI」と呼ばれ、投資家たちは文字通りこの「新しい」テクノロジーに数十億ドルを投じていた。

しかし、実際に検証してみると、AIはまったく新しいものではない。

アップルの女性音声「Siri」やアマゾン・ドット・コムの女性音声「アレクサ」は、話し言葉に反応して返事を返してくれる。これは「AI」であり、10年以上前から存在している。

新しいLLMアプリケーションのような「生成的AI」で「新しい」のは、応答を計算するパワーとエネルギーが大幅に拡張され、コンピュータがテキストを素早く生成しながら、あたかもあなたと会話しているかのように見えることだ。

しかし、これらのLLMは実際には新しい何かを生み出すわけではない。SiriやAlexaのようなプログラムを動かしている古いテクノロジーが、まだ大人のような話し方を学んでいない赤ちゃんに思えるほどのスピードで、そのデータを素早く計算することができるのだ。

しかし、学習させるデータの量と精度にはまだ限界がある。データを操作することで新しい言語構造を「作り出す」ことはできるかもしれないが、データそのものを作り出すことはできないのだ。

別の見方をすれば、現実の世界でそれが行っていることは、核となるデータを正確に表現しないことで、人間をより優れた嘘つきにしているということになる。

最近、グーグルの新しい携帯電話のコマーシャルを見ていて、この嘘をつく能力の強化に本当に驚かされた:

ここでグーグルは、写真のように “AI “を使って人々を欺き、グーグル携帯が撮影した実際のデータについて嘘をつく方法を明らかに教えている。

ウソをついたり人をだましたりすることは売れるが、真実は売れないことが多い。グーグルの最新携帯電話のこのようなコマーシャルを一般の人々が見ると、ほとんどの人は、これは本当に素晴らしいことだと反応するだろう。

今日のビッグテックの世界では、”データ “は新しい通貨であり、”データ主義 “は新しい宗教である。

もし、私が昨年発表したゼカリア・リンチの記事をまだお読みでないなら、この記事を読んで、テクノクラートたちがどこに行こうとしているのか、少なくともどこに行こうとしているのかを鋭く観察してほしい:

「データ主義」はAIとトランスヒューマニズムの新宗教である:データを所有し支配する者が人生を支配する

最近の記事で述べたように、これらのLLMモデルを訓練している人々は、”データが不足している “という理由でパニックを起こし始めている。

このことは、新しいLLM AIモデルのもうひとつの重大な欠陥を浮かび上がらせる。既存のデータから生成されるものはすべて、誰かが作成し、インターネット上にカタログ化されたデータなのだ。つまり、このAIによって生成されるものは、それが正確であろうとなかろうと、盗用であるということだ!

このテクノロジーは急速に進歩しているため、法的な意味合いについてはまだ十分に議論されていないが、私は昨年初めに、テキストやグラフィックを生成するためにAIを使わないと決めた。

何十年もそうしてきたように、今日も記事を書くときは、自分の記事で使用するすべてのものの原典を引用し、信用に値するところには信用を与えるよう最善を尽くしている。

LLMのAIは一般的にこれをしない。AIには魂がなく、善悪の概念もない。それは単にスクリプトに従うだけであり、アルゴリズムと呼ばれる人間によってプログラムされたコンピューターのスクリプトに従うだけなのだ。

現在、コンピュータにデータを入力できる方法は限られており、文字、マイクによる音声、カメラによる画像や動画などである。

この3つの方法だけでなく、嗅覚や味覚など、まだデジタルデータに変換できない感覚も含めてデータを入力できる人間に、コンピューターやAIプログラムが取って代わることはないだろう。

しかし、人間が持つ最大のデータ収集能力は、非物理的、つまり「メタ物理的」なものである。

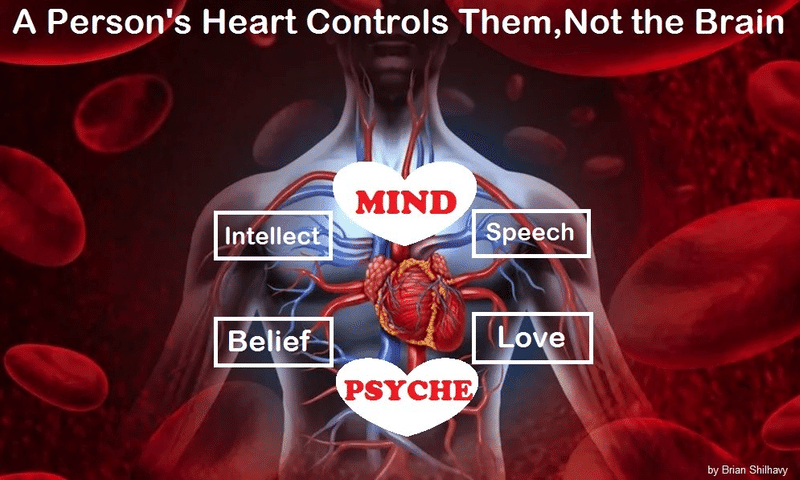

何百年にもわたるダーウィンの生物学的進化論は、ほとんどの西洋人に脳が意識の中心であることを教えてきたが、古代人は何千年もの間、常に心臓が意識の中心であると信じてきた。

これは、聖書やその他の古代文献の見解である。見てみよう:

脳の神話:知性と思考は脳ではなく心に由来する

そして「現代科学」には、この信念を否定するものは何もない。

昨年このトピックで書いたように、どちらかといえば、私たちの人生における心の中心的な位置を確認する科学的証拠がある。

その証拠とは、心臓移植を受けた人が、心臓を提供した人が生前に経験したことを思い出したり、考えたりするという話である。

他人の脳の移植を受けた人はいない。

『Medical Hypotheses』誌に掲載された2020年の研究では、実際にこの問題に取り組んでいる。

要旨

心臓移植後の性格の変化については何十年も前から報告されているが、その中にはレシピエントがドナーの性格的特徴を獲得するという記述も含まれている。この論文では、性格変化の4つのカテゴリーについて議論する:(1)嗜好の変化、(2)感情・気質の変化、(3)アイデンティティの変化、(4)ドナーの生前の記憶である。心臓移植後のレシピエントによるドナーの性格特性の獲得は、細胞記憶の伝達を介して起こるという仮説が立てられ、(1)エピジェネティック記憶、(2)DNA記憶、(3)RNA記憶、(4)タンパク質記憶の4種類の細胞記憶が提示されている。その他、心臓内神経記憶やエネルギー記憶を介した記憶の伝達などの可能性についても論じている。現在の死の定義を再検討することの重要性、記憶の伝達が提供された心臓の統合にどのような影響を与えるかを研究すること、他の臓器の移植によって記憶を伝達できるかどうかを決定すること、心臓移植によってどのような種類の情報を伝達できるかを調査することなど、心臓移植の将来への示唆が探求されている。さらなる研究が推奨される。(Source)

こちらも参照のこと:

臓器移植レシピエントにおける記憶の転移

ドナーの特徴を受け継いだ10人の臓器レシピエント

抜粋

クレア・シルヴィア、奇妙な欲求と夢を抱く – ニューイングランド

47歳のクレア・シルヴィアが受けた心臓と肺の移植は、彼女の命を救っただけでなく、ニューイングランドで初めてこの移植を受けた人になった。彼女はまた、重要な臓器に加え、ドナーの嗜好の一部を受け取ったと確信している。まるで彼の記憶が彼の心臓と肺に閉じ込められ、その結果、彼女の体に流れ込んだかのように。

彼女はある記者に、手術後にまず何をしたいかと聞かれたとき、「今すぐビールが飲みたくてたまらない 」と答えたと語った。それまでビールを少しも楽しんだことがなかったクレアにとって、これは不思議なことだった。数日後、彼女はまた、ピーマン、スニッカーズのチョコレートバー、そして不思議なことにマクドナルドのチキンマックナゲットなど、これまで好きでもなく、食べたことすらなかった食べ物が食べたくなっていることに気づいた。

奇妙な夢も見るようになった。ティムと呼ばれる痩せた若い男を見るのだ。

具体的には、夢の中で 「ティム・L 」という言葉が頭に浮かんでいた。移植当日までの数日間、地元の死亡記事を検索したところ、ティモシー・ラミランドに行き当たった。

ティモシー・ラミランドは18歳で、クレアの移植と同じ日にオートバイ事故で亡くなった。彼は地元のマクドナルドから帰宅する途中だった。医師が彼の命を救うために必死で衣服を脱がせたとき、上着のポケットからチキンマックナゲットの袋が見つかった。

彼女は初対面だったティムの家族を探し出し、彼女が抱いていた食欲は、ティムがビールも含めてとても好んで食べていたものであることを確認した。

それ以来、彼女はティムの家族と連絡を取り続けている。(記事全文)

ABCニュースが8年前に公開した、脳がほとんどない状態で生まれた赤ちゃんについて、そして脳がない状態では生きる見込みがないため、医師がどのように両親に中絶を告げたかについてのビデオである。

しかし、両親は医師の忠告を聞かず、赤ん坊のジャクソンは脳なしで6年近く生きた。医師や医学に逆らって彼がそうすることができたのは、彼の意識が脳ではなく、元気だった心臓にあったからである。

電気で動くAIやコンピューターは、心臓から送り出される血液で動く人間に取って代わることはない。

AIについてもっと読む

「人工知能」の75年にわたる失敗の歴史と、現実世界のためにSFに投資して失われた数十億ドル

コンピューターが利用できない 「データ」

いいえ、私たちは神の秘密の知恵について語っています。それは隠されていた知恵であり、時の始まる前から神が私たちの栄光のために定めておられた知恵です。この時代の支配者たちは誰もそれを理解していませんでした。もし理解していたなら、栄光の主を十字架につけることはなかったでしょう。

しかし、聖書にこう書いてあります。「神を愛する者たちのために神が用意しておられるものは、目が見たこともなく、耳が聞いたこともなく、心に思い浮かんだこともない。」しかし、神は御霊によってそれを私たちに明らかにしてくださったのです。

御霊はすべてのこと、神の深遠なことにさえも探究します。

人間の心を知る者は、その人の内にある霊以外にはだれがいるでしょうか。

同じように、神の御霊のほかに、だれも神の思いを知る者はいません。

私たちはこの世の霊を受けたのではなく、神から出た霊を受けたのです。それは、神が私たちに惜しみなく与えてくださったものを、私たちが悟ることができるようになるためです。(コリント人への第一の手紙 2:7-12)

コメント